-

Ceph集群中删除RBD_CephFS以及Pool池

由于之前实验创建了很多RBD存储池以及对应的镜像,并且在cephfs也有很多垃圾数据,后面不需要使用了,所以我这边介绍下如何删除RBD、CephFS、以及Pool存储池 [root@ceph-01 ~]# ceph osd pool ls .rgw.root default.rgw.control default.rgw.meta default.rgw.log default.rgw.bucke…- 935

- 0

-

Ceph Object Storage Daemon takes too much time to resize_Ceph OSD剔除节点重新添加OSD集群

告警日志为如下: Ceph Object Storage Daemon takes too much time to resize. ceph集群监控异常 使用ceph osd命令查看osd状态 [root@ceph-01 ~]# ceph osd tree ID CLASS WEIGHT TYPE NAME STATUS REWEIGHT PRI-AFF -1 0.27338 root defa…- 407

- 0

-

ceph集群提示daemons have recently crashed

完整报错如下 [root@ceph-01 ~]# ceph -s cluster: id: c8ae7537-8693-40df-8943-733f82049642 health: HEALTH_WARN 2 daemons have recently crashed services: mon: 3 daemons, quorum ceph-01,ceph-02,ceph-03 (age 24m…- 718

- 0

-

Ceph osd Full OSDs blocking recovery: 12 pgs recovery_toofull 磁盘空间不足

元旦早上收到ceph告警,mgr发送告警并没有提示告警内容是什么问题。只是提示我ceph健康为error。告警截图如下 此时查看grafana告警也是异常的状态 接下来进入服务器排查问题 [root@ceph-01 ~]# ceph -s cluster: id: c8ae7537-8693-40df-8943-733f82049642 health: HEALTH_ERR 2 backfillf…- 571

- 0

-

Ceph Dashboard用户权限控制

ceph dashboard默认支持多用户,多权限管理,并且支持https认证,同时ceph不仅仅支持网页配置用户权限,并且还支持命令行创建。本次采用yum 安装的ceph进行展示用户权限的控制以及对应的管理- 1.4k

- 0

-

Ceph 异常告警 1 daemons have recently crashed

具体ceph状态如下 [root@ceph-01 ~]# ceph -s cluster: id: c8ae7537-8693-40df-8943-733f82049642 health: HEALTH_WARN 1 daemons have recently crashed 告警内容如下 Dashboard告警如下 但是实际上mgr节点也已经恢复了,节点并没有解除 [root@ceph-01 ~…- 1.4k

- 0

-

ceph mds MDS_INSUFFICIENT_STANDBY insufficient standby MDS daemons available

[root@ceph-01 ~]# ceph health detail HEALTH_WARN insufficient standby MDS daemons available MDS_INSUFFICIENT_STANDBY insufficient standby MDS daemons available have 0; want 1 more 这个报错内容基本上是触发了我们ceph …- 635

- 0

-

Ceph集群提示insufficient standby MDS daemons available

ceph集群健康检查出现问题,提示insufficient standby MDS daemons available 具体信息如下 [root@ceph-01 ~]# ceph -s cluster: id: c8ae7537-8693-40df-8943-733f82049642 health: HEALTH_WARN insufficient standby MDS daemons avai…- 1.7k

- 0

-

Kubernetes(k8s) 1.23.5 csi-ceph cephfs使用手册

目前官方Ceph csi版本已经支持Kubernetes 1.23,但是如果我们直接使用最新的ceph csi。在创建cephfs的时候会出现storageclass 创建pvc pending的状态。并且错误日志会提示persistentvolume-controller waiting for a volume to be created, either by external provisi…- 2.4k

- 0

-

Ceph ceph-csi查看版本号

在ceph csi pod里面是没有可以sh的地方,如果我们需要看最新的版本号,可以在GitHub中查看 第一步: 打开https://github.com/ceph/ceph-csi 选择build.env文件 截至2022年7月25日,最新的ceph-csi查看版本号在build.env。默认ceph deploy安装的版本号为N版,稳定版;请一定要保证ceph-csi和ceph集群版本在同一…- 708

- 0

-

PVC提示persistentvolume-controller waiting for a volume to be created, either by external provisioner “cephfs.csi.ceph.com” or manually created by system administrator

PVC报错内容 [root@k8s-01 ceph]# kubectl describe pvc data Name: data Namespace: default StorageClass: csi-cephfs-sc Status: Pending Volume: Labels: <none> Annotations: volume.beta.kubernetes.io/stor…- 1.3k

- 0

-

K8s CephFS: mount failed: mount failed: fork/exec /usr/bin/systemd-run: invalid argument

在使用pod挂载cephfs挂载pod错误日志如下 Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal Scheduled 13m default-scheduler Successfully assigned default/nginx-pod1 to k8s-02 Warning FailedMou…- 844

- 0

-

Linux客户端远程挂载Ceph RBD并设置开机启动自动挂载

当我们安装完ceph集群后,集群外的机器想使用Ceph集群内创建的rbd文件。那么,就需要安装Ceph的客户端,也就是rbd客户端,以及一些RBD专用的内核模块。 步骤也相对简单,关于集群搭建,以及ceph原理可以看下面的文章,此处不过多介绍安装和原理部分 环境信息 Ceph集群信息 [root@ceph-01 ~]# ceph -s cluster: id: c8ae7537-8693-40df…- 1.8k

- 0

-

Ceph install ceph-common提示Error: Package: 2:postfix-2.10.1-9.el7.x86_64 (base)

当使用yum install -y 安装ceph-common提示下面依赖的问题 Error: Package: 2:postfix-2.10.1-9.el7.x86_64 (base) 解决方法 #备份旧的源 mkdir /etc/yum.repos.d/old mv /etc/yum.repos.d/* /etc/yum.repos.d/old #配置centos、epeo、ceph源 cur…- 575

- 0

-

Prometheus监控Ceph集群并设置AlertManager告警

之前写过ceph的搭建,那么我们ceph同样也需要prometheus进行监控数据。我这里使用prometheus监控ceph并配置alertmanager告警- 2.3k

- 1

-

Error EINVAL: Please specify the file containing the password/secret with “-i” option.

ceph dashboard创建密码时提示如下 [root@ceph-03 ~]# ceph dashboard ac-user-create abcdocker admin administrator Error EINVAL: Please specify the file containing the password/secret with "-i" option. 最…- 845

- 0

-

Error ENOENT: all mgr daemons do not support module ‘dashboard’, pass –force to force enablement

当我们开启mgr-dashboard提示如下报错时 [root@ceph-01 ~]# ceph mgr module enable dashboard Error ENOENT: all mgr daemons do not support module 'dashboard', pass --force to force enablement 需要在ceph-mgr mas…- 1.5k

- 0

-

Prometheus Grafana使用Ceph持久化并监控k8s集群

随着时间的更新,早期写过的Promethues监控k8s和grafana这一块文章已经有需要修改的地方。并且以前使用nfs为pod进行持久化,本地修改为使用ceph进行持久化,版本也进行更新迭代- 1.5k

- 0

-

Kubernetes(k8s) 1.24 csi-ceph rbd使用手册

在Kubernetes中经常需要持久化的地方,很早之前都是使用nfs。但是nfs不支持rbd格式,不支持块存储级别。ceph目前是在kubernetes属于比较流行的存储引擎,支持rbd、cephfs等。本次我使用最新版kubernetes 1.24以及N版ceph进行演示- 3.4k

- 0

-

Ceph RGW高可用集群部署

RGW 简介 Ceph Object Gateway也称为对象网关 ,RGW支持S2协议和SWIFT协议对外提供对象存储,两者的对象访问方式均以HTTP方式访问。用户的对象经由RGW处理后,会最终存放在后端RADOS系统。 对象网关对外提供兼容S3和SWIFT的API 存储网关RGW负责客户端接入 RADOS协议实现数据存储(Libradio是Rados提供库,因为RADOS是协议很难直接访问,因…- 1.3k

- 0

-

-

Ceph集群日常使用命令

一、Ceph 集群服务维护 之前文章说了一下ceph的安装,安装其实比较简单,但是后续维护起来我们需要知道常用的维护命令 第一种,一次性重启所有服务 如果我们机器上osd、mon、rgw等服务都安装在一个节点,可以通过下面的命令直接管理所有服务 ceph target allowing to start/stop all ceph*@.service instances at once [root…- 2.2k

- 0

-

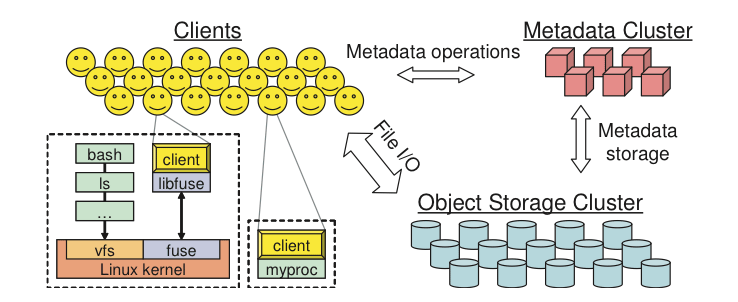

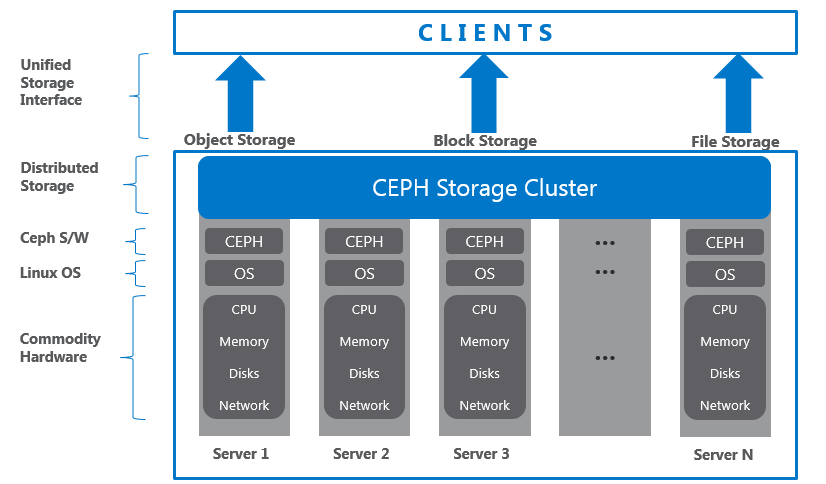

Ceph基础知识和基础架构

一、Ceph概述 这里简单的说一下相关的组件,只是简单介绍 组件 概念 Monitor 一个Ceph集群需要多个Monitor组成的小集群,它们通过Paxos同步数据,用来保存OSD的元数据 OSD OSD负责相应客户端请求返回具体数据的进程,一个Ceph集群一般都有很多个OSD MDS MDS 全称Cepg Metadata Service,是CephFs服务依赖的元数据服务 Object Ce…- 1.9k

- 0

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!